Lu, Jiahao, et al. "APRIL: Finding the Achilles' Heel on Privacy for Vision Transformers"

The Third AAAI Workshop on Privacy-Preserving Artificial Intelligence (PPAI-22)

https://arxiv.org/abs/2112.14087

https://aaai-ppai22.github.io/#accepted_papers

Federated learning frameworks typically require collaborators to share their local gradient updates of a common model instead of sharing training data to preserve privacy. However, prior works on Gradient Leakage Attacks showed that private training data can be revealed from gradients. So far almost all relevant works base their attacks on fully-connected or convolutional neural networks. Given the recent overwhelmingly rising trend of adapting Transformers to solve multifarious vision tasks, it is highly valuable to investigate the privacy risk of vision transformers. In this paper, we analyse the gradient leakage risk of self-attention based mechanism in both theoretical and practical manners. Particularly, we propose APRIL - Attention PRIvacy Leakage, which poses a strong threat to self-attention inspired models such as ViT. Showing how vision Transformers are at the risk of privacy leakage via gradients, we urge the significance of designing privacy-safer Transformer models and defending schemes.

배경 지식

- Gradient Leakage Attack

- 악의적인 공격자가 공유된 가중치를 분석하여 원본 데이터를 완벽하게 복원할 수 있는 취약점이다.

논문에서 고려하는 두가지 트랜스포머 형태

(A) : Multi-haed 어텐션, 정규화, VGG 스타일의 MLP를 쌓은 인코더 모듈

(B) : ViT 에서 소개된 실환경 구축 (Dosovitskiy et al. 2020)

점선의 빨간 상자로 표시되어 있는 Multi-head 어텐션의 인풋으로 임베딩 레이어의 출력이기 때문에, Closed-From (폐쇄형) APRIL 공격의 전제 조건을 만족한다.

반대로 Optimization-based (최적화 기반) APRIL 공격은 노란 점선 상자로 표시된 (A)와 (B)의 모든 아키텍처에 적용이 가능하다.

먼저 Self-attention 모듈을 다음과 같이 가정한다.

여기서 z는 self-attention 모듈의 입력값이고, a는 모듈의 출력이다.

Q, K, V, W가 쿼리, 키, 값, Projection 을 의미하고, q, k, v, h 가 중간 특징맵을 나타낸다.

그리고 손실 함수는 다음과 같이 가정한다.

그리고 입력값 z 와 관련하여 loss l 의 도함수는 다음과 같다.

여기서 파라미터 Q, K, V 를 끌어낼 수 있으며,

입력값 z를 양변에 곱함으로써 Federated Learning (연합 학습)에서 공유된 파라미터가 공격자에게 노출된다.

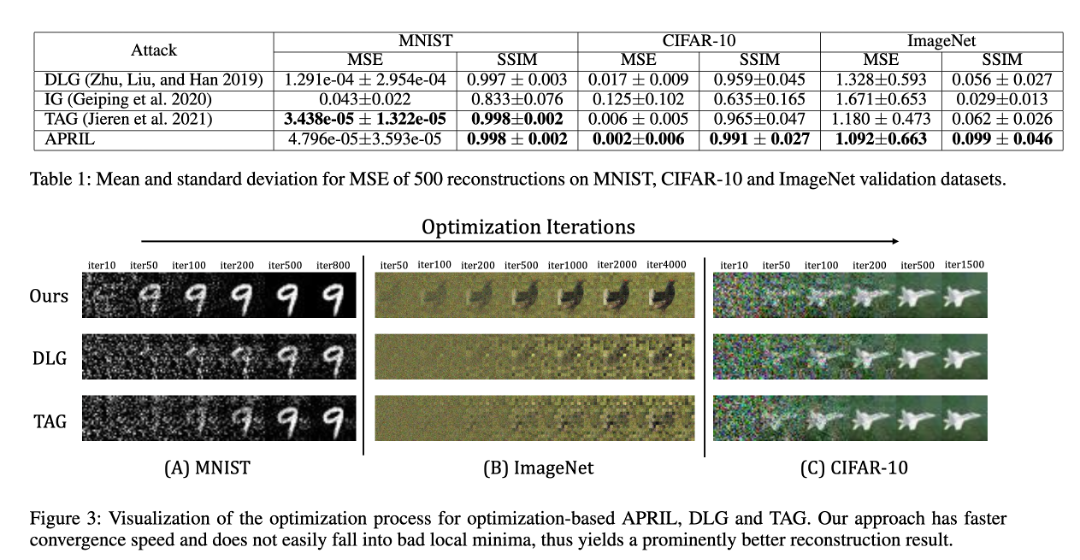

논문에서 제안한 방법의 또 하나의 변형 기법으로 최적화 기반 APRIL 공격을 통해 학습 가능한 위치 임베딩에서 그래디언트 매칭을 적용시키면 비전 트랜스포머에서 프라이버시를 쉽게 깰 수 있다는 것을 보였다.

실험에 있어서는 APRIL 공격을 위에서 언급한 아키텍처 (A)에 적용하고 다른 공격 방식과 비교했을 때, 아래 그림에서 볼 수 있듯 폐쇄형 APRIL 공격은 원래 입력과 거의 차이가 없는 완벽한 재구성을 보여주어 그 정확성을 입증하였다.

그리고, 시각화와 별개로 폐쇄형 공격을 정량적 비교로 표로 나타내었을 때도, 거의 모든 작업 환경에서 일관되게 최상의 결과를 얻는 성능을 나타내었다.

이로서 APRIL이 Transformer의 맥락에 있어서서는 기존의 모든 개인 정보 보호 공격 접근 방식을 능가함으로 비전 트랜스포머에 강력한 위협이 됨을 증명하였다.

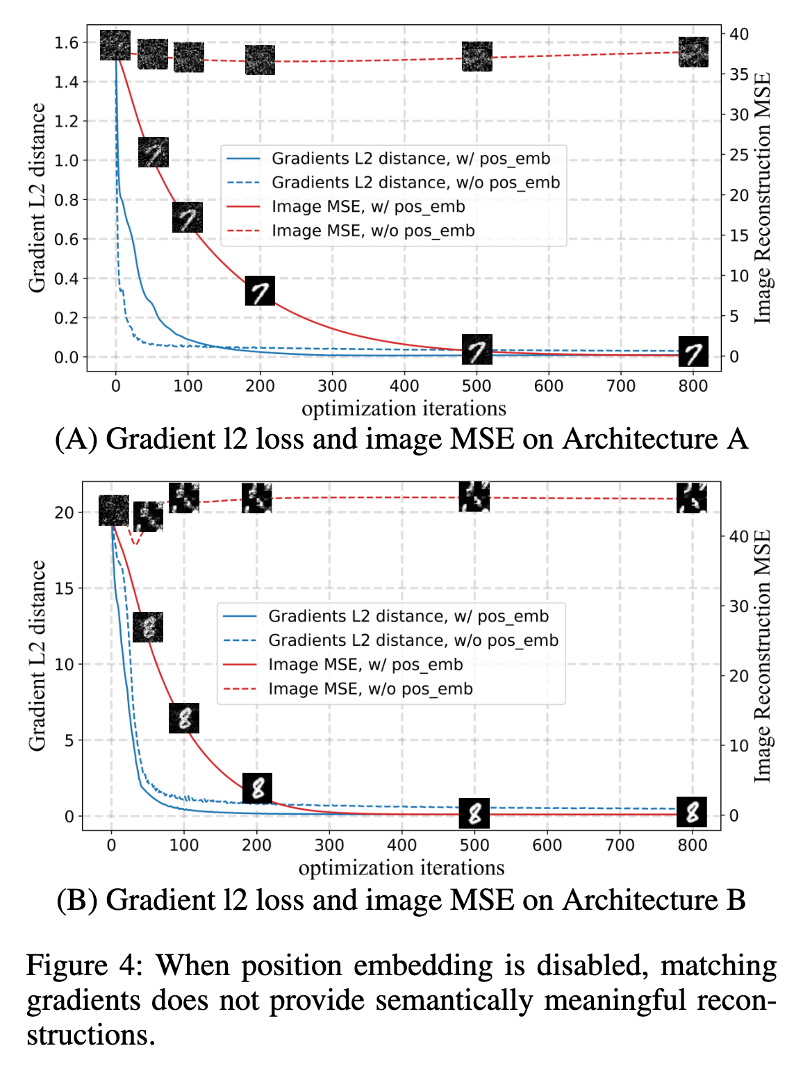

방어전략으로는 학습 가능한 위치 임베딩을 고정 위치로 바꾸어, 클라이언트가 입력과 그레디언트를 공유하지 않도록 하는 것이다.

위치 임베딩 그레디언트 공유를 중단한 후, 최적화는 시각적으로 일그러진 데이터를 생성하여 실측 데이터와 유사한 그레디언트를 매개로 한다.

이러한 최적화 프로세스는 아래 차트로 나타내었으며, 이로서 매우 효율적인 방식으로 프라이버시를 보호하게 된다.

'Security' 카테고리의 다른 글

| [Security] Jenkins 'Security Advisories' 로 Jenkins 플러그인 취약점 관리하기 (0) | 2024.07.30 |

|---|---|

| [Security] Kubernetes에 Shift-Left 테스팅 적용하기 (0) | 2024.07.30 |

| [Security] CIS (Center of Internet Security) Benchmarks (0) | 2023.10.23 |

| [Security] 적대적 기계학습 (Adversarial Machine Learning) (0) | 2023.10.16 |

| [논문] Benchmarking differentially private synthetic data generation algorithms (0) | 2022.12.21 |